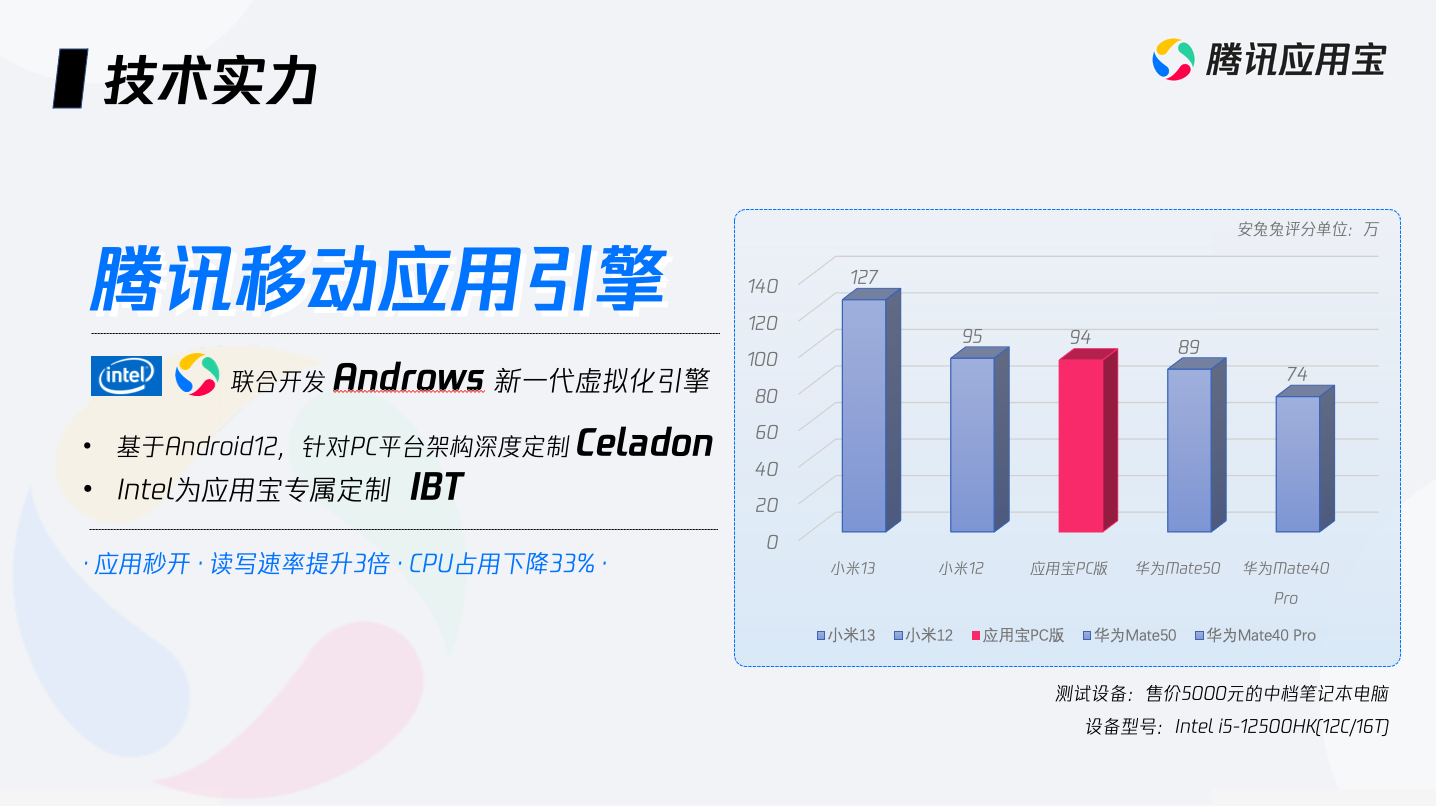

背景 我一直网易的mumu模拟器听小宇宙或者微信读书,我基本不去玩游戏,每次用的时候笔记本的风扇转的比较厉害,导致影响发自己写代码,一直想找别的模拟器,但感觉同类的模拟器反而没有这个好,直到我用微软商店应用宝(专区) 微软商店应用宝专区 这个在微软商店中的腾讯专区,在左边最下边就是了。 下载里面APP或者搜索APP,找到带有应用宝图标的就是这个专区的APP 第一次下载这个APP,会提示下载需要组件,这个组件就是腾讯和intel合作研究 Androws 框架,这个就是用来跑APP的容器,大概下载700M多,后面这个容…

scrcpy wifi连接无法常亮 我自己开发软件发现无法常亮,这样子用起来就非常不方便,然后我研究了scrcpy,他虽然有一个--stayway on 的命令,但我发现这个只有连接usb才会保持常亮。 过程 分析Scrcpy 只是设置setting 手机属性而已,电源管理设置而已,但如果用wifi没有效果了,因为我没有充电,但这样子如果我挂机软件或者游戏感觉用起来就不方便了。 我发现anlink可以做到。 分析anlink 我猜测他用什么adb命令,我懒的逆向分析,直接用火绒剑分析进程行为,我发现他使用了命令 a…

一、背景 开源scrcpy 用adb forward 进行转发,这样子不用知道电脑的IP,直接给PC指定端口发送数据就会传送到手机端 二、问题 自己在开发自己协同工具的时候,发现虽然转发,但流量还是在手机显示,而用alink(基于开源的scrcpy开发),却没有显示流量。 三、解决过程 自己命令: adb forward tcp:9990 tcp:9990 他们用的: adb forward tcp:9990 localabstract:local 我发现他们用localServersocket而不是Sersock…

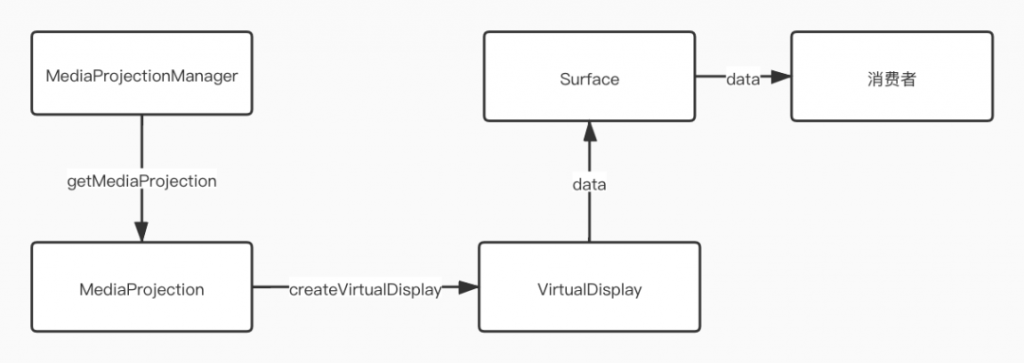

一,背景 最近用一直都有研究这类技术,我总算把大概技术搞清楚了。 二,开源代码 1,minicap openstf/minicap: Stream real-time screen capture data out of Android devices. (github.com) 用c++ 编译ndk 可执行程序,用的ndk私有API,所以他依赖aosp代码,所以有适配问题,如果系统魔改很厉害化,可能就无法运行,兼容性比其他开源感觉会差一些,毕竟底层so变化挺大,不是接口。 2,scrcpy Genymobile/…

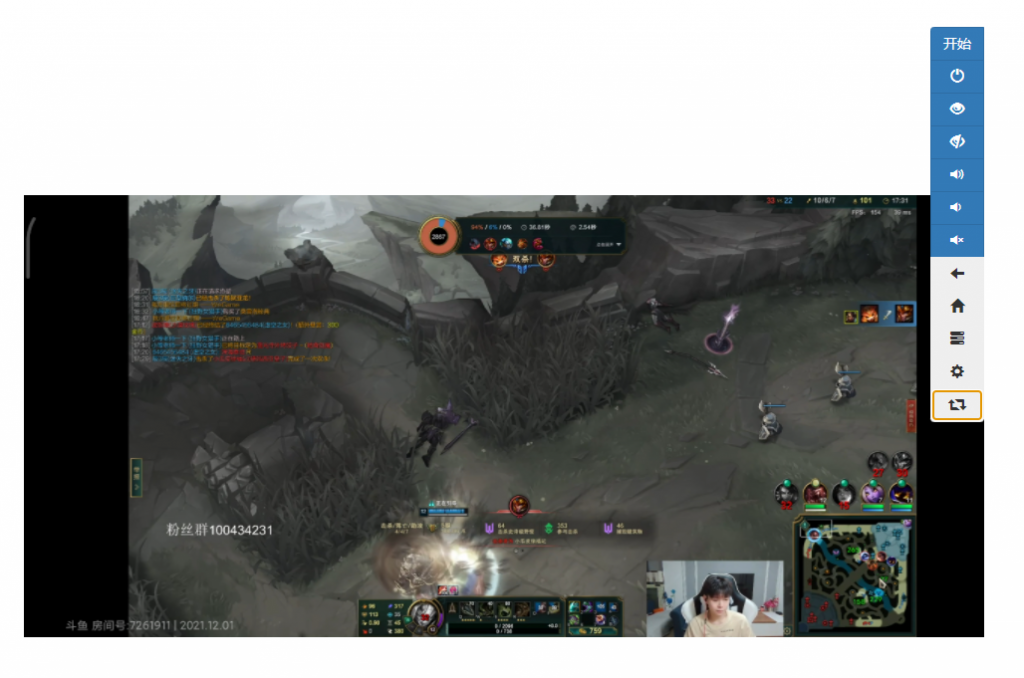

一,背景 自己无意见发现虫洞这个软件,PC可以控制android,发现FPS 非常流程,于是触发我的好奇心,研究几天,大概知道商业用哪种技术。 二,思路 1,网上直接找就是adb shell screencap -p /stcard/xx.png,然后拉取图片,显示图片 这种用我自己的手机测试大概是2秒左右,太迟太大,结合我自己写的c语言的代码,每次启动一个新的adb来截图,所以时间基本更长。 2:上面进化版本 adb exec-out screencap -p > test.png 在手机端不存放普通,通过…

自己写自动化时候发现会出现null的情况,并不是切换窗口太快导致问题,自己根据网上资料大概下面几种情况 ,设置如下就可以了: android:canRetrieveWindowContent="true" 没有设置,导致获取不到焦点 android:accessibilityFlags="flagDefault|flagRetrieveInteractiveWindows|flagIncludeNotImportantViews" 属性不够,导致认为一些为不重要属性节点 窗口没有焦点,一般情况不会出现。 暂时记录一…